News

2023.08.07

知財ニュース

Meta、テキストから画像・画像からテキストの両方を生成するAI「CM3leon」発表―自己回帰モデルの可能性を拡張

米Metaは現地時間7月14日、テキストから画像、画像からテキストの両方を生成するAIモデル「CM3leon(カメレオン)」を発表した。言語モデルを学習させチューニングして構築した、初のマルチモーダル言語モデルで、MetaのAI研究を担うMeta AIが開発。テキストから画像・画像からテキストのいずれかに対応する、既存モデルの機能拡張を実現したという。

画像生成AIは今、拡張モデルが主流だ。拡張モデルは、画像にノイズを当て完全にノイズになった状態から遡り、画像の再構築する過程を学習させたAIモデルで、OpenAIの「DALL-E」やStability AIの「Stable Diffusion」などがそれに該当する。

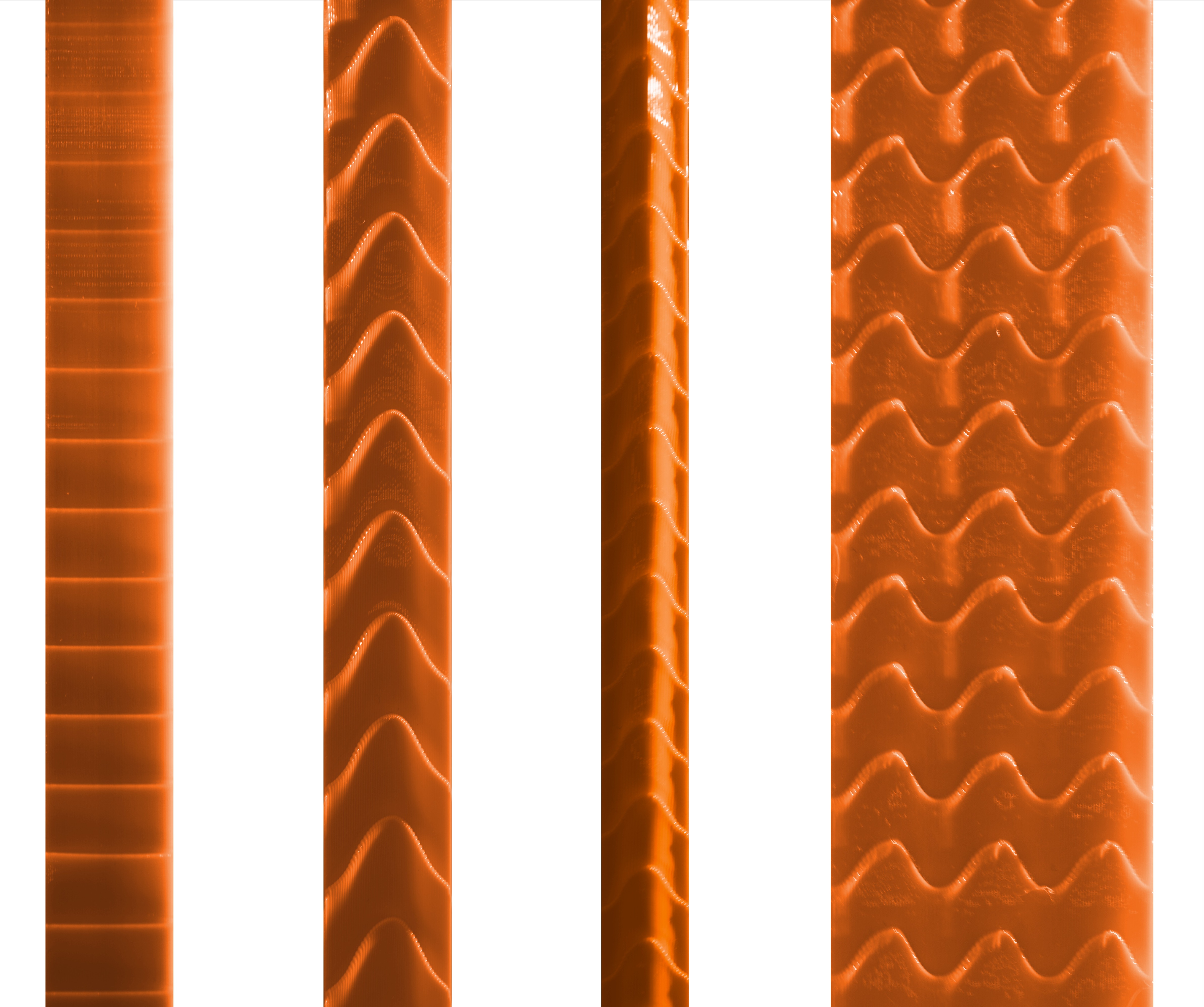

Metaは今回、拡張モデルではなく、テキストのみの生成に用いられてきた自己回帰モデルを活用。文章を語彙に分割したトークンベースで、過去データにもとづいて予測・結果データを導き出すAIモデルを用いた。さらに、教師データを用いて学習を別の設問でも活用できるよう微調整するファインチューニング(SFT)を行い、「CM3leon」を構築した。

自己回帰モデルは、生成画像の一貫性を向上する手法と認識されながらも、計算コストの高さなどから、これまであまり画像生成に用いられてこなかった。

「CM3leon」は、テキストと画像の両方を含むマルチモーダル文書で学習した生成モデル「CM3」を用いて、チューニングを実施。従来モデルよりも5倍少ない計算量で、最先端の性能を実現したという。

画像生成性能のベンチマークである、「zero-shot MS-COCO」のFID(Fréchet inception distance)のスコアは4.88を達成。これは、Googleの画像生成AI「Parti」の性能を上回った結果となる。わずか30億のテキストトークンで構成されるデータセットで学習しても、この性能に違いは出ないとしている。

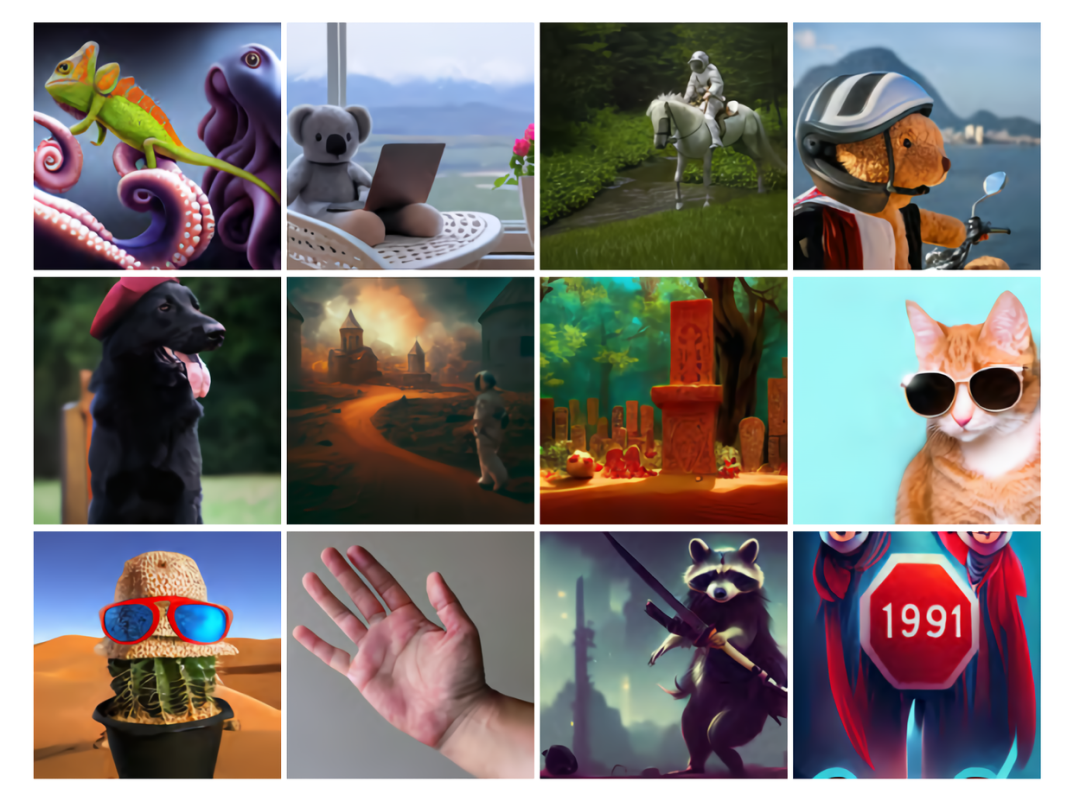

「CM3leon」では、複雑な構成を持つオブジェクトやテキストプロンプトが与えられても、プロンプトに沿った画像の生成が可能。これは、AIがテキストの指示と画像の両方を理解できるためという。例えば、以下のオリジナル要素を含んだ画像は、左から1~4のプロンプトで生成している。

1, A small cactus wearing a straw hat and neon sunglasses in the Sahara desert.

(サハラ砂漠で麦わら帽子をかぶり、サングラスをかけた小さなサボテン)

2, A close-up photo of a human hand, hand model. High quality.

(人間の手のクローズアップ写真、高画質)

3, A raccoon main character in an Anime preparing for an epic battle with a samurai sword. Battle stance. Fantasy, Illustration.

(侍の刀で壮大な戦いに備えるアニメのアライグマの主人公、戦闘態勢、ファンタジー、イラスト)

4, A stop sign in a Fantasy style with the text “1991.”

("1991 "の文字が入ったファンタジー風の一時停止標識)

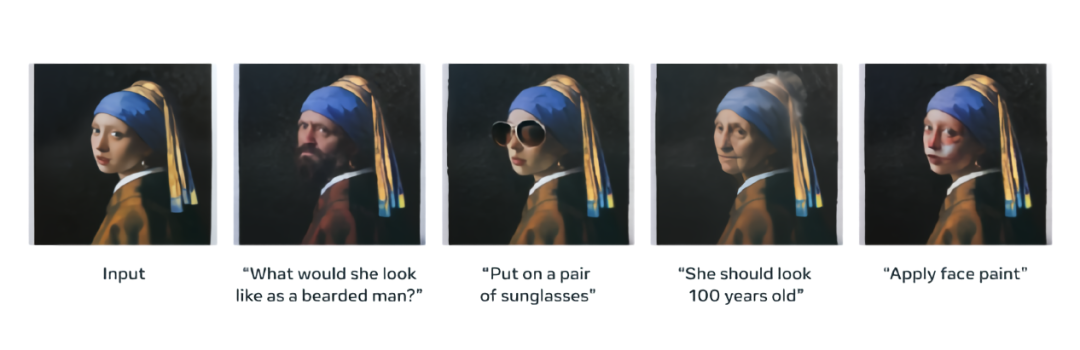

画像とテキストプロンプトが与えられた際は、テキストの指示に沿い画像編集を行う。テキストガイド付きの画像編集用にチューニングされたAIモデルとは異なり、単一のモデルで実現できる点が特徴だ。

画像のキャプションを長・短文で生成したり、画像に関する質問に答えることも可能。例として、下の画像に関する以下のやり取りを紹介している。

Prompt Question: What is the dog carrying?(犬は何を運んでいますか)

Model Generation: Stick.(棒)

Prompt: Describe the given image in very fine detail.(画像の詳細説明をしてください)

Model Generation: In this image, there is a dog holding a stick in its mouth. There is grass on the surface. In the background of the image, there are trees.

(この画像では、犬が棒をくわえています。地面には草が生えています。背景には木があります)

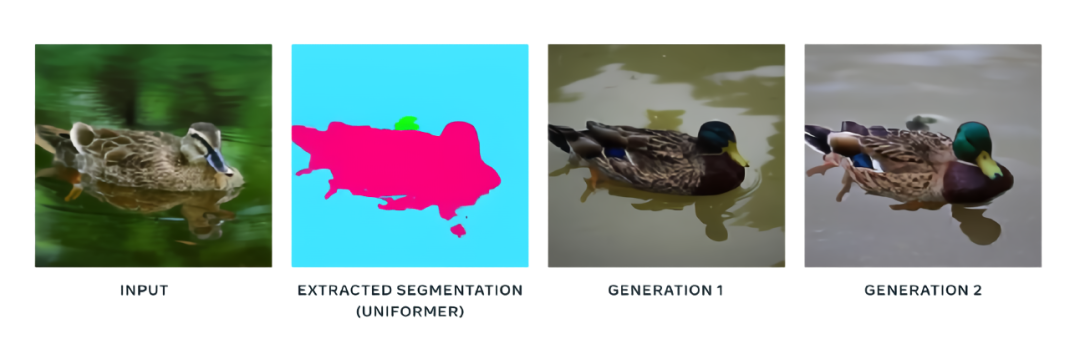

Metaは、その他にもタスクパフォーマンスを紹介している。例えば、画像の構造を理解し元の構造やレイアウトを守りながら画像編集を行う、画像のバウンディングボックスの脇に表示されるテキスト説明を用いて画像生成する、セグメンテーションのみを含む画像を指定し画像生成するなどが可能という。

同社は発表文書の中で、「CM3leonのようなモデルは、最終的にメタバースにおける創造性を高め、より良いアプリケーションを後押しすることができるだろう」とし、「マルチモーダル言語モデルの境界を探求し、今後さらに多くのモデルをリリースすることを楽しみにしている」と述べている。

「CM3leon」のリリース時期などは、現時点では明らかにされていない。だが、AIの可能性を拡げたMetaの取り組みが、生成AIの開発をさらに加速させそうだ。

関連ブログ

技術論文 ” Scaling Autoregressive Multi-Modal Models: Pretraining and Instruction Tuning”

Top Image : © Meta