News

2025.02.17

知財ニュース

Meta、脳波から文章を解読するAIモデル「Brain2Qwerty」を開発

Metaは、脳波から文章を解読するAIモデル「Brain2Qwerty」を開発したと発表した。

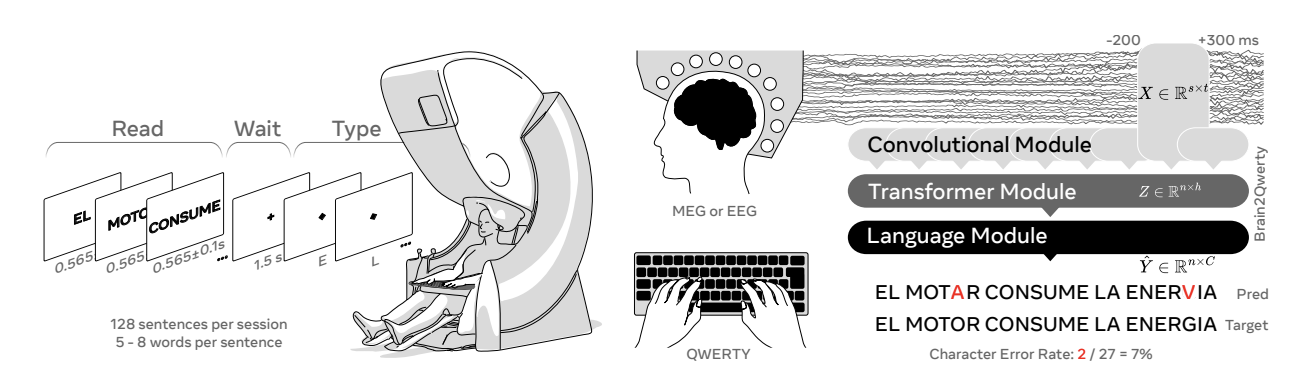

「Brain2Qwerty」は、非侵襲的に記録された脳活動からテキストを解読するように訓練されたディープラーニングアーキテクチャだ。35人の健康なボランティアの参加者で有効性を実証したのだという。

MEG(脳磁図)とEEG(脳波)の両方を使用して、35人の参加者が文章を入力している様子を記録した。次に、AIモデルをトレーニングして、脳信号のみから文章を再構築した。

実験の結果、Brain2Qwertyの文字エラー率(CER)は平均32%で、EEGの67%を大幅に上回った。参加者の中には、19%の文字エラー率(CER)を達成した人もいたとのことだ。

同社は、この研究は話す能力を失った人々のコミュニケーション能力を回復させるのに役立つ非侵襲性のブレインコンピューターインターフェースの新たな道を切り開く可能性があると述べている。しかしこのアプローチを臨床現場に適用するには、まだ課題が残っているのだという。

1つ目はデコードのパフォーマンスがまだ不完全であること。2つ目はより実用的であること。なぜなら、MEGの使用は、被験者が磁気シールドされた部屋でじっとしている必要があるからだ。また、この研究は健康なボランティアを対象に行われたが、脳損傷に苦しむ人々にどのような利益をもたらすかを探るには、今後の研究が必要だとしている。

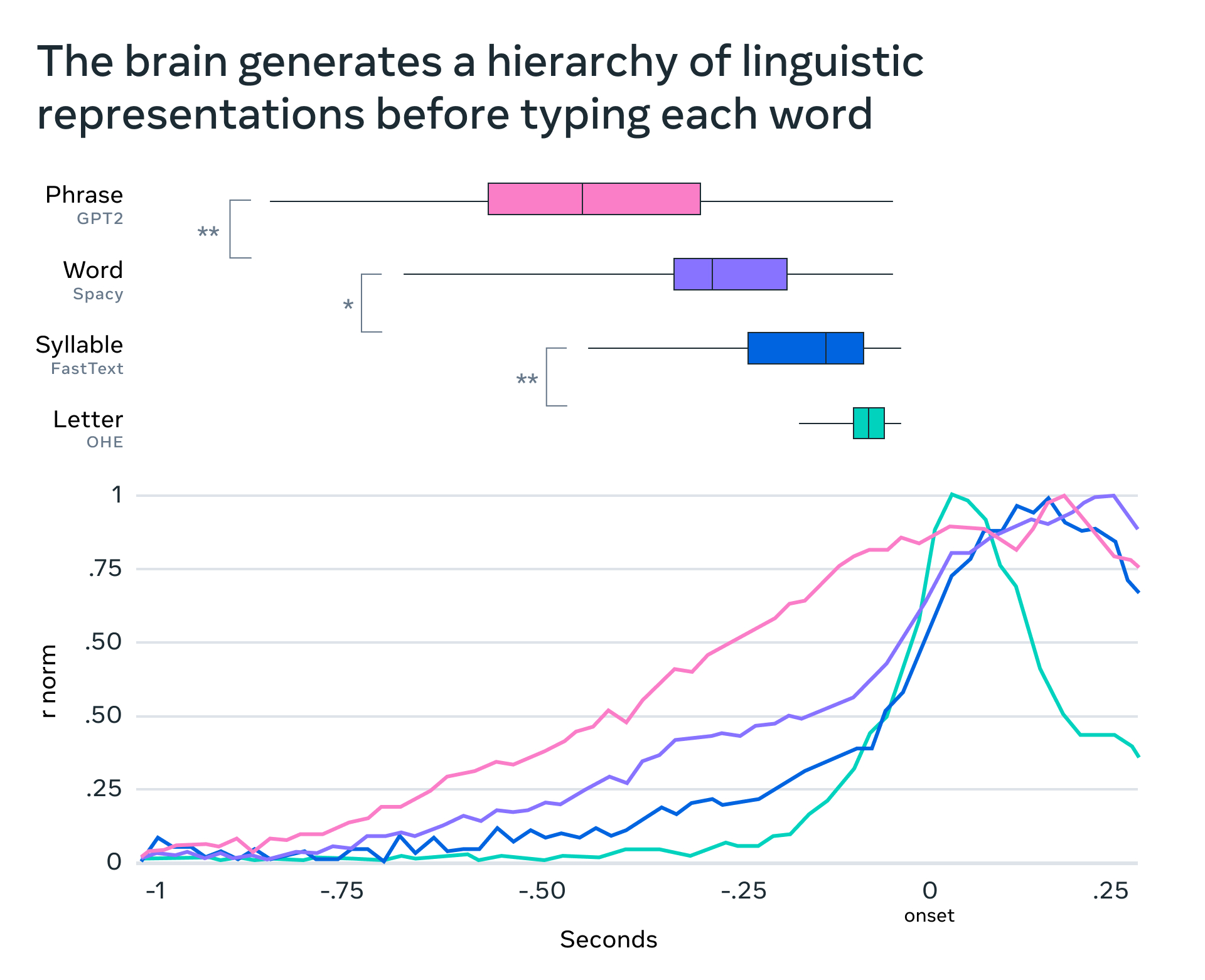

さらに、MetaはAIを使って脳がどのように言語を形成するかを理解する研究も行っている。脳が思考を複雑な一連の運動動作に変換する仕組みを探るため、参加者が文章を入力しているときにAIを利用してMEG信号を解釈。毎秒1000 枚の脳のスナップショットを撮ることで、思考が単語、音節、文字に変換される正確な瞬間を特定する。

この研究では、脳が最も抽象的なレベルの表現 (文章の意味) から始まる一連の表現を生成し、実際の指の動きなど、無数のアクションに徐々に変換していることが示されているのだという。また、この研究によって脳が連続する言葉や行動を首尾一貫して同時に表現する方法も明らかになったとのことだ。

Top Image : © Meta