News

2023.05.25

知財ニュース

Apple、障がいをサポートする認知・発話・視覚などのアクセシビリティ機能を発表─23年後半に提供予定

米Appleは現地時間5月16日、認知、発話、視覚などのアクセシビリティを支援する複数の機能を発表した。障がい者や発話能力を失うリスクがある人を対象に、認知負荷を減らす機能や、合成音声を作る機能などを提供する。2023年後半あたりの提供開始を予定している。

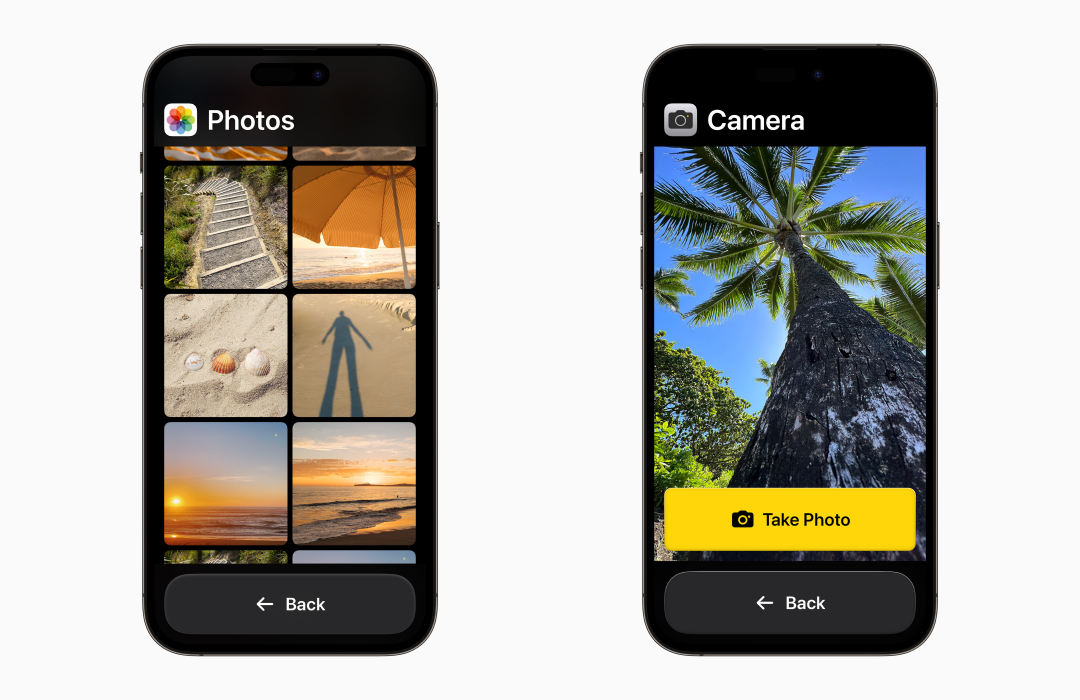

新機能「Assistive Access」では、認知的負荷軽減をサポートする。電話やメッセージ、カメラなど本質的な機能にフォーカスし、認知的負荷を軽減するインターフェースを提供。高コントラストのボタン、大きな文字のラベルなどで表示し、使いやすく操作をサポートする。

例えば、ユーザーの好みに応じて、メッセージのキーボードを絵文字のみすることも可能。レイアウトは、グリッドベースかテキストが見やすい行ベースかを選択できる。

発話のサポート機能としては「Live Speech」と「Personal Voice」を提供する。

「Live Speech」は、ユーザーが話したいことを文字で入力すると、iPhoneやiPadなどが読み上げてくれる機能。電話やFaceTime通話の際や、対面での会話中に活用できる。事前によく使うフレーズを保存しておき、会話の際にそのフレーズを流すことも可能だ。

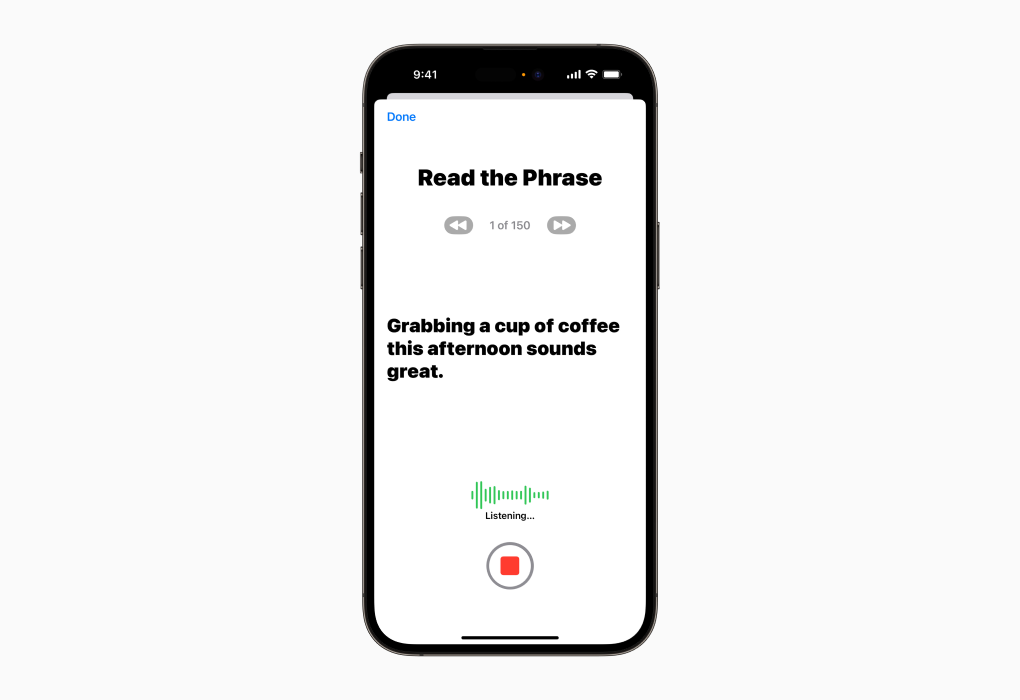

「Personal Voice」は、自分の合成音声を簡単に作れる機能。ユーザーは、iPhoneまたはiPadが表示した一連のテキストを読んで音声を15分間録音すると、合成音声を作成できる。「Live Speech」と組み合わせて使用可能で、話す能力を失うリスクがある人や、時間の経過とともに言葉を失った人でもあらかじめ登録した音声を用いて自分に似た声を作成でき、自分が話しているように会話できるという。

Appleは、ALS(筋萎縮性側索硬化症)や、発話能力を失う可能性がある病気を患った人などの利用を想定。音声生成にあたっては、デバイス上の機械学習を用いるため、プライバシーやセキュリティは守られるという。

視覚サポートには「Point and Speak」機能を提供する。iPhoneとiPadに以前から搭載されている拡大鏡アプリに組み込まれる機能で、カメラやLiDRスキャナー、端末内の機械学習からの入力と組み合わせて、認識した対象物のテキストラベルを音声で読み上げ、目の見えないユーザーや視力の低いユーザー向けに指差して話す機能であり、ユーザーの操作をナビゲートする。

画像内容を音声で説明するVoiceOver機能やカメラなど、既存機能と連動して動作する。日本語含む11言語に対応する予定という。

その他、聴覚障がいを持つ人向けに、iPhoneのヒアリングデバイスをMacとペアリングして、快適な聴こえ方になるようカスタマイズできる機能や、身体障がいを持つ人がiPhoneとiPadの任意のスイッチをゲームコントローラーに変えて、ゲームをプレイできる機能など。複数機能が公開されている。

Appleは、様々な障がいのあるユーザーを代表する地域団体と協力関係を築き、メンバーからフィードバックを受けながら今回の開発を進めてきたという。ティム・クックCEOは今回の機能発表に際し、「最高のテクノロジーはすべての人のために作られるテクノロジーだ」とコメントしている。

Top Image : © Apple Inc.

この記事のタグ