News

2023.04.12

知財ニュース

Meta、画像内のあらゆるオブジェクトを切り取るAIモデル「Segment Anything Model」を公開

米MetaのAI部門であるMeta AIは現地時間4月5日、画像内のオブジェクトをセグメンテーション(区分、分類)する新たなAIモデル「Segment Anything Model(SAM)」を公開した。

画像処理のセグメンテーションは元々、画像の各ピクセルがどのオブジェクトに属するか特定することで、画像分析や写真編集などに用いられている。これまでAIでセグメンテーションを行う場合は、注釈・タグ付けされた大量の画像データによる機械学習や、専門技術者のモデリング知識などが必要だった。

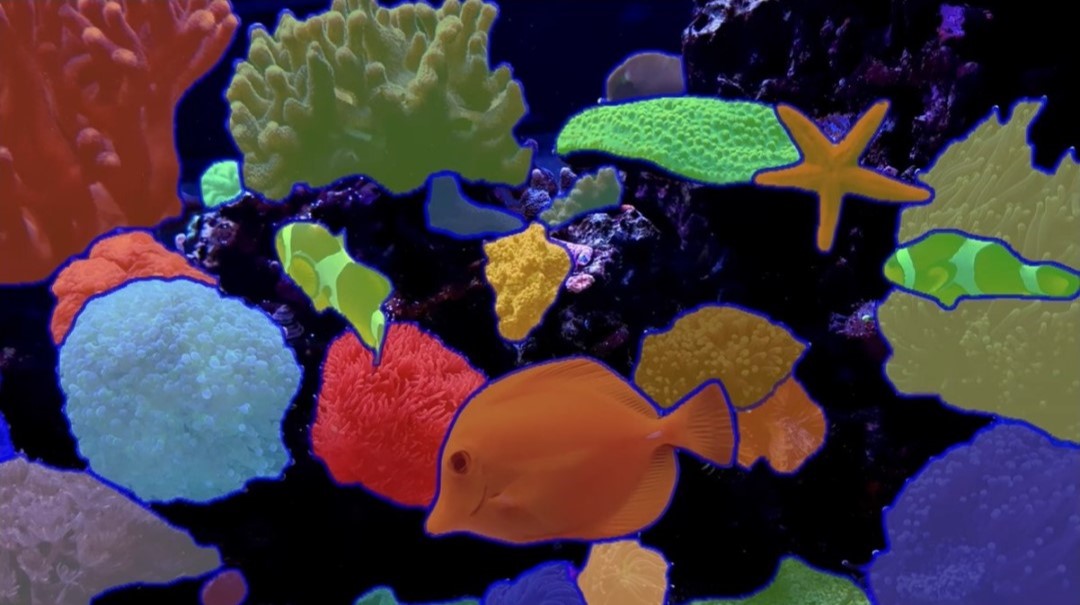

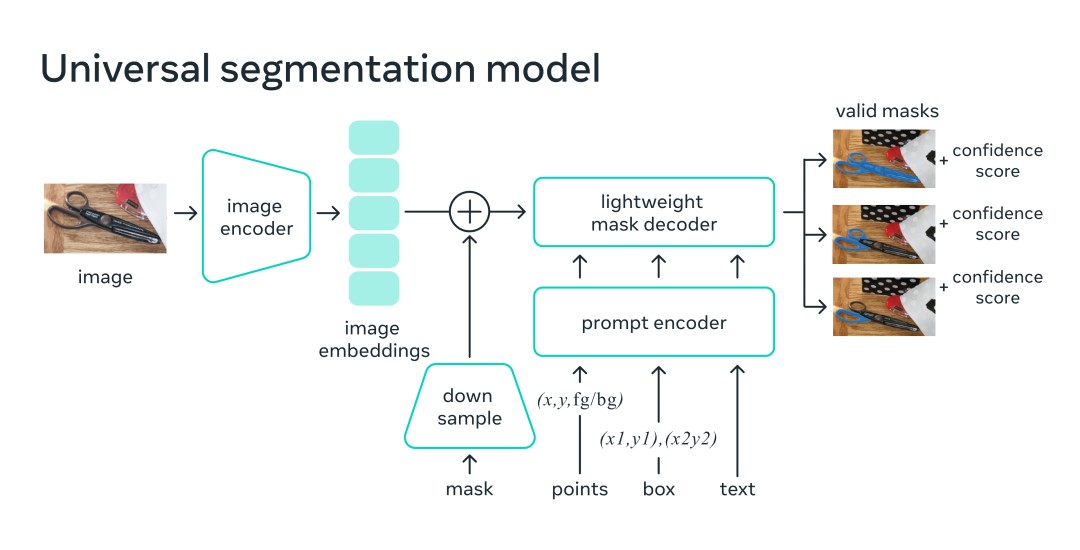

「Segment Anything Model(SAM)」は、Meta AIが写真提供会社から入手した約1,100万枚の画像をもとに、事前にオブジェクトに関する機械学習を実施済み。クリックなどの複数の入力方法に対して有効なマスクを返すようトレーニングしている。そのため、水中写真や細胞顕微鏡などの毛色の異なる画像でも追加の機械学習なしに使用できるという。

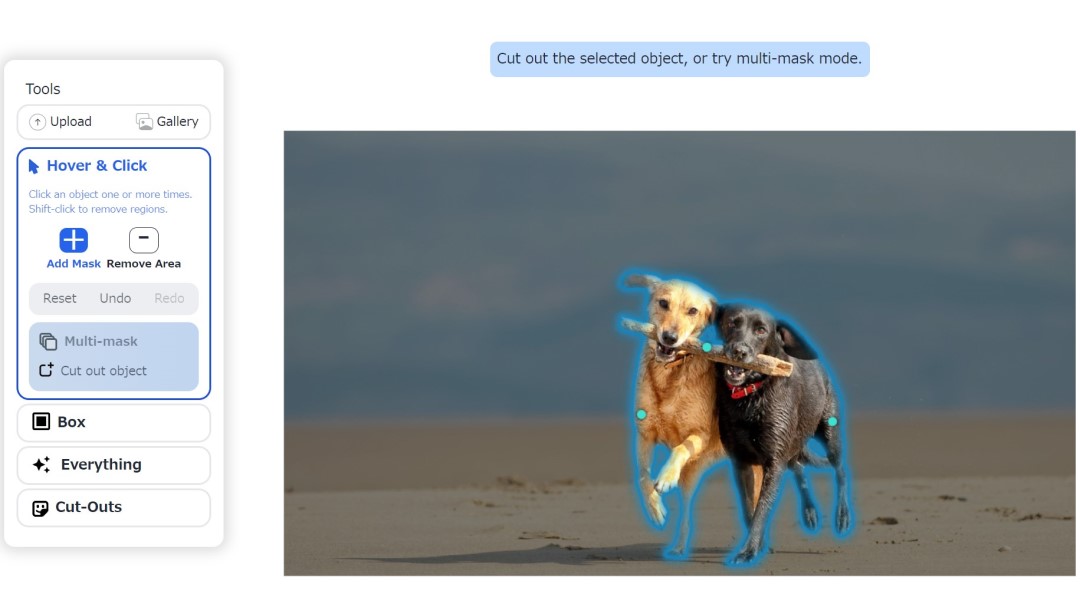

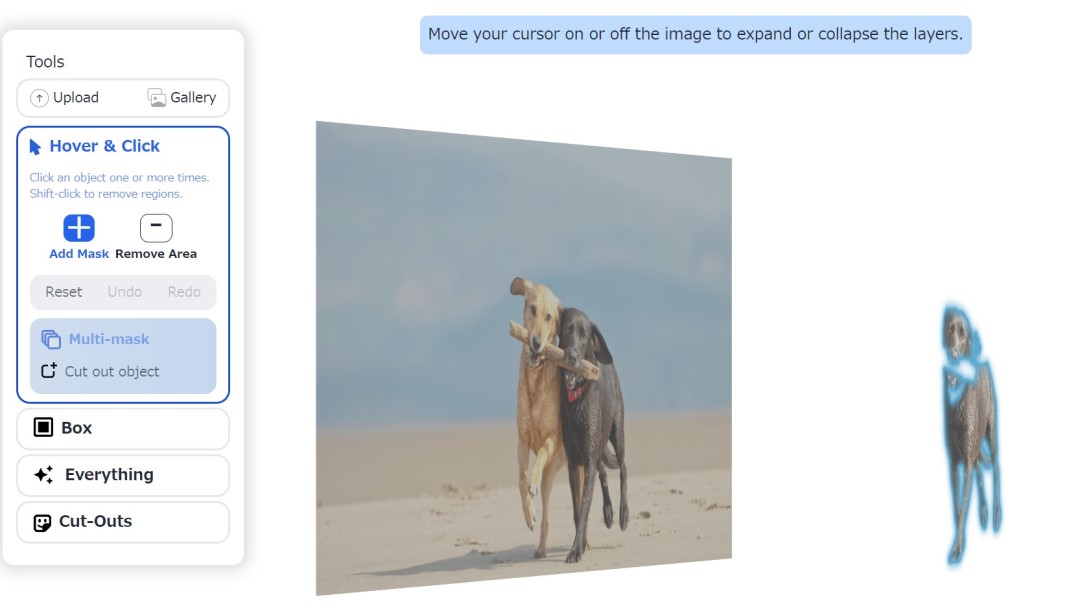

SAMの公開と共に開設されたデモページでは、画像を用いて実際にセグメンテーションの体験ができる。サイトの掲載画像だけでなく、手元の画像をアップロードして試すことも可能だ。

セグメンテーションを行う方法として、画像オブジェクトのクリックや、BOXによる選択、AIによる自動判定など複数のアプローチが用意されている。オブジェクトが曖昧な場合には、複数のマスクを生成する「multi-mask」機能も備えている。

またMeta AIはSAMと併せて、セグメンテーション用のデータセット(SA-1B)の提供も開始。データセットには、1,100万枚のライセンス取得済み画像と、プライバシー保護された画像から収集した11億枚以上のセグメンテーションマスクが含まれている。マスク数は、従来のセグメンテーションデータセットの400倍という。SA-1Bは、研究目的に限り、オープンライセンス(Apache 2.0)で使用可能だ。

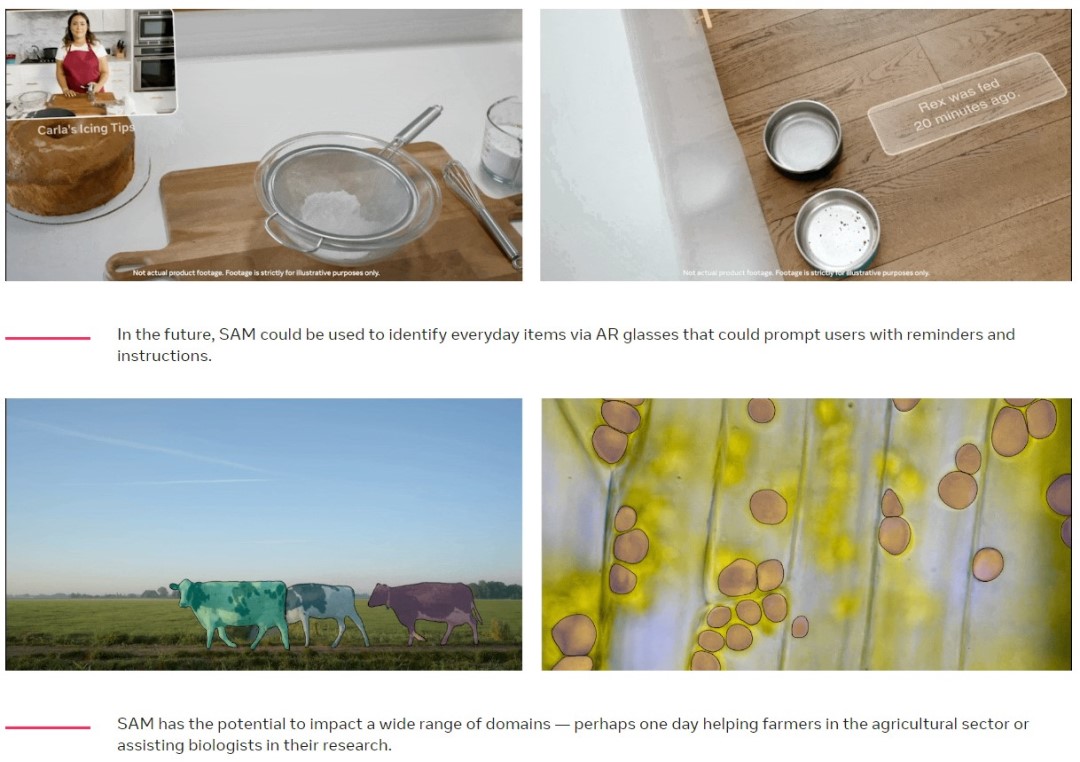

Meta AIは、SAMの将来的な展開を多数想定している。例えば、WEBサイトのヴィジュアルとテキストなど複数情報を用いて高度な判断を行う、マルチモーダルなAIシステムの構成要素になる可能性があるという。

AR/VRの分野では、ユーザの視線をもとにオブジェクトを特定して3D画像を生成したり、ARメガネで品物を識別しユーザの視界に注意喚起情報を掲載するなどを想定。

ほか、動物や物体の位置特定・ビデオ追跡などによる地球・宇宙で起こる自然現象の研究支援や、画像制作・ビデオ編集の際の画像領域抽出での活用なども見込んでいる。多様な領域での今後の進展が期待される。

リリースはこちら

Meta AI Blog 関連記事

「Segment Anything Model」の紹介ページ

「Segment Anything Model」デモサイト

データセット(SA-1B)提供ページ

Top Image : © Meta