News

2023.08.16

知財ニュース

Stability AI、70億パラメータの日本語生成AI「Japanese StableLM Alpha」公開─既存モデルを上回る性能スコアを達成

英Stability AIの日本法人であるStability AI Japanは8月10日、生成AIの技術基盤となる日本語言語モデル「Japanese StableLM Alpha」を一般公開した。公開したのは、日本語向け汎用言語モデル「Japanese StableLM Base Alpha 7B」と、指示応答言語モデル「Japanese StableLM Instruct Alpha 7B」。70億パラメーターの言語モデルで、現在一般公開されている日本語向けモデルでは最高の性能を有するという。

「Japanese StableLM Base Alpha 7B」は、Webを中心とした大規模データを用いてテキスト生成を学習した、汎用言語モデルだ。言語モデルの学習には、EleutherAIのライブラリ「GPT-NeoX」を発展させたソフトウェアを利用している。

学習データには、Webのオープンデータに加え、同社が作成したデータセットや、EleutherAI 多言語プロジェクトの日本語チームとStability AI JapanのDiscordコミュニティから提供されたデータなどを用いた。主に日本語と英語で学習しており、ソースコードが2%含まれる。学習は、延べ7,500億トークンで行われたという。

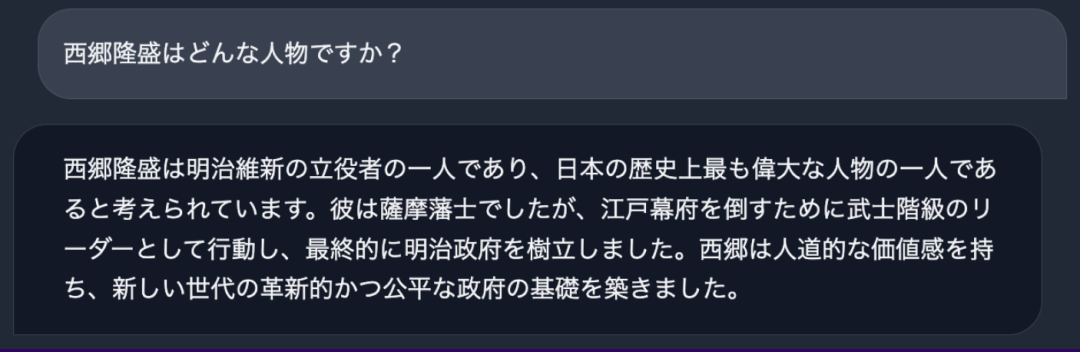

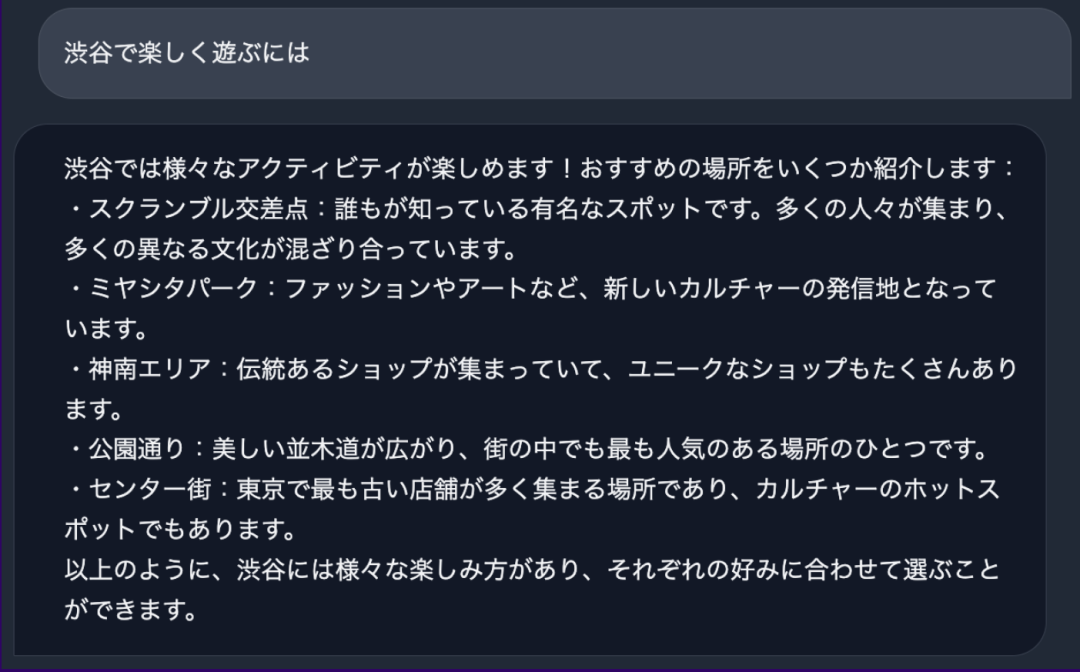

「Japanese StableLM Instruct Alpha 7B」は、上記の汎用言語モデルに追加学習を行い、ユーザーの指示に応用できるようにした指示応答言語モデル。追加学習には、教師データを用いて学習を別の設問でも活用できるよう微調整するファインチューニング(SFT)を採用。複数のオープンデータセットで学習させたという。

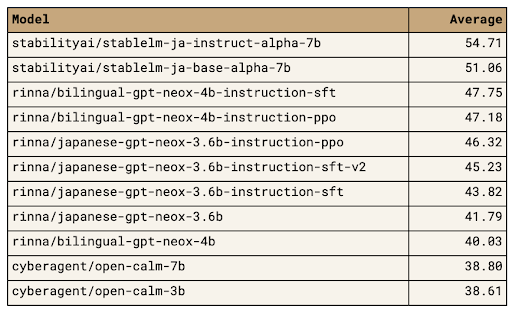

追加学習の結果、「Japanese StableLM Instruct Alpha 7B」の性能は高いスコアを達成。日本語言語理解ベンチマーク(JGLUE)のタスクを軸に、文章分類や質疑応答、文章要約などの計8タスクで性能比較したところ、平均スコアは54.71で、他のモデルを大きく上回ったとのこと。

2つのモデルは現在、AI技術の研究開発データを公開・共有するプラットフォーム「Hugging Face」で公開している。汎用言語モデル「Japanese StableLM Base Alpha 7B」は、商用利用可能。「Japanese StableLM Instruct Alpha 7B」は、研究目的で構築されたモデルのため、商用利用はできない。

Stability AI Japanは、公開した2つのモデルを「Japanese StableLM Alpha シリーズ」と呼び、手がけた最初の生成基盤モデルと位置付けている。同社は今後も、日本向けの生成基盤モデルを構築・公開していく方針だ。近い将来、日本語による生成AI開発の飛躍的な進展が見込まれる。

ニュースリリースはこちら

「Japanese StableLM Base Alpha 7B」Hugging Faceページ

「Japanese StableLM Instruct Alpha 7B」Hugging Faceページ

Top Image : © Stability AI