News

2024.05.29

知財ニュース

Apple、iPhoneやiPadを「目で操作する」アクセシビリティ機能を発表―乗り物酔い軽減機能も登場

米Appleは現地時間2024年5月15日、2024年後半に提供開始予定の新しいアクセシビリティ機能を発表した。身体・聴覚・発話などの障がいを持つ人をサポートする複数の機能が登場する。iPhoneやiPadを目だけで操作可能な「Eye Tracking」や、新しい音楽体験を提供する「Music Haptics」などを追加。音声認識機能も強化する。また、乗り物酔いを軽減する「Vehicle Motion Cues」などの提供も予定している。

目でiPhoneやiPadを操作できる「Eye Tracking」機能は、身体障がいを持つユーザーのために設計された。デバイスのフロントカメラで目の動きをトラッキング。ボタンやアイコンなどの上にポインターを一定時間置くと動作する「Dwell Control」を組み合わせており、ボタン選択やスワイプ、その他のジェスチャーなどを操作できる。iOSとiPadOSのアプリに対応し、数秒の設定と調整で利用可能。追加のハードウェアやアクセサリーは必要ない。

「Music Haptics」は、iPhoneで耳が不自由なユーザー向けに新たな音楽体験を提供する。iPhoneに搭載された触感フィードバックを行う「Taptic Engine」を用いており、音楽に合わせて微細な振動を再生する。Apple Musicの数百万の楽曲に対応。アプリ開発者向けにAPIの提供も予定している。

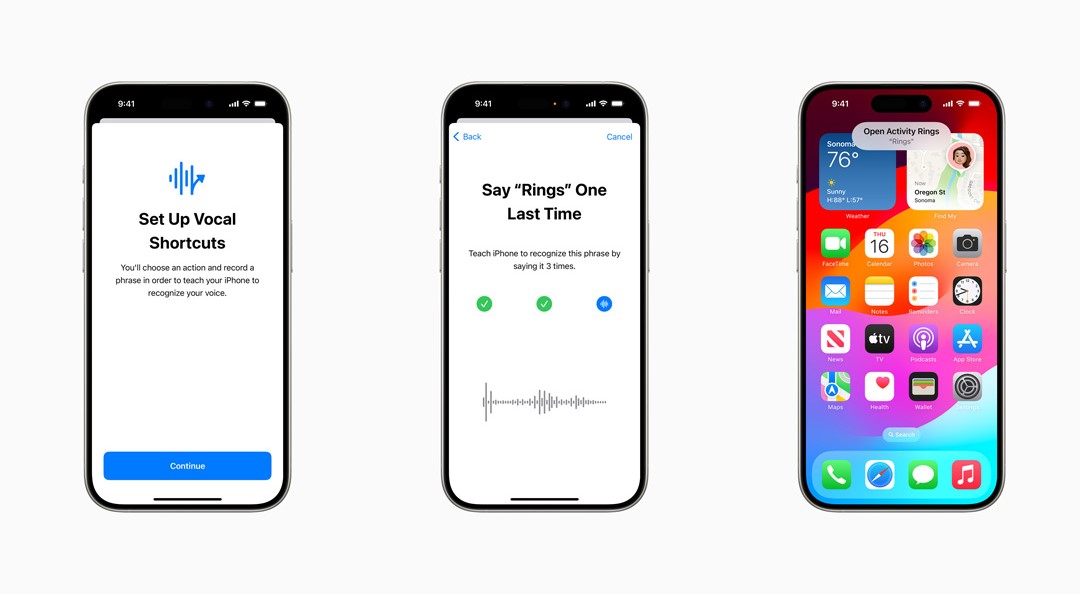

発話による操作をサポートする機能も搭載する。iPhone/iPadユーザー向けの「Vocal Shortcuts」では、Siriが理解できるカスタム発話を割り当てて、ショートカットの起動や、複雑なタスクを行うことができる。また、音声の聞き取りを強化した「Listen for Atypical Speech」も提供。デバイス上の機械学習により、ユーザーの発話パターンを学んで認識する。これらは、脳性まひ、筋萎縮性側索硬化症(ALS)、脳卒中など、発話に影響を及ぼす疾患を持つユーザーを想定した機能で、一般的な発話が難しい場合でも音声認識や音声による操作をサポートする。

iPhone/iPad向けに乗り物酔いを軽減する「Vehicle Motion Cues」も追加する。乗り物酔いは一般的に、見ているものと感じているものの間の感覚の衝突が原因とされている。同機能では、画面の端に車両の動きを表現するドットのアニメーションを表示して、感覚の衝突を軽減する。表示は、デバイスに内蔵されたセンサーで、ユーザーが乗り物に乗っていることを認識して行う。自動表示するよう設定でき、オン・オフの切り替えも可能だ。

車両にiPhone を接続してルート案内や電話など多様な機能を使える「CarPlay」の、音声コントロールとアクセシビリティ機能もアップデートする。声だけでCarPlayを操作できるボイスコントロールを追加。色覚障がいのあるユーザー向けに、インターフェースを見やすくするカラーフィルターや文字を太字にする機能も提供する。また、他車のクラクションやサイレンが鳴っていることをアラートで通知する、耳の不自由なユーザーをサポートする機能も盛り込む。

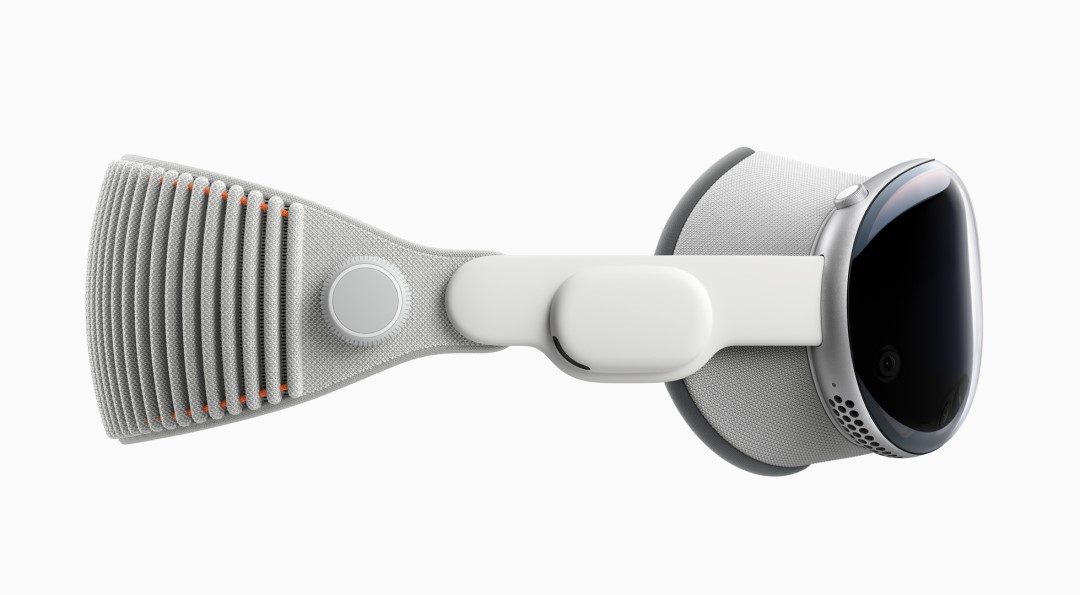

visionOS もアップデートする。会議などライブの文字起こしを行う機能を提供。ヘッドマウントデバイスの「Apple Vision Pro」でApple Immersive Videoを使っている時に、ウィンドウバーを使ってキャプションを移動する機能を追加する。また、iPhone用の聴覚デバイスと人工内耳のサポート機能も強化。弱視のユーザーや明るい光や頻繁な点滅を避けたいユーザー向けに、透明度を下げる・スマート反転する・点滅を暗くするといった機能を提供する。

ほかにも複数の機能追加を予定している。例えば、視覚障がいを持つユーザーをサポートする、VoiceOverの新しい音声や柔軟なボイスローダー、点字画面入力での日本語対応などを提供。また、デバイス操作を補助するスイッチコントロールには、iPhoneとiPadのカメラで指をタップするジェスチャーを認識し、スイッチを作動させるオプション機能を搭載する。今回発表した新機能の追加で、障がいを持つ人だけでなく、あらゆるユーザーの操作性を高めそうだ。

Top Image : © Apple Inc.