No.856

2024.06.07

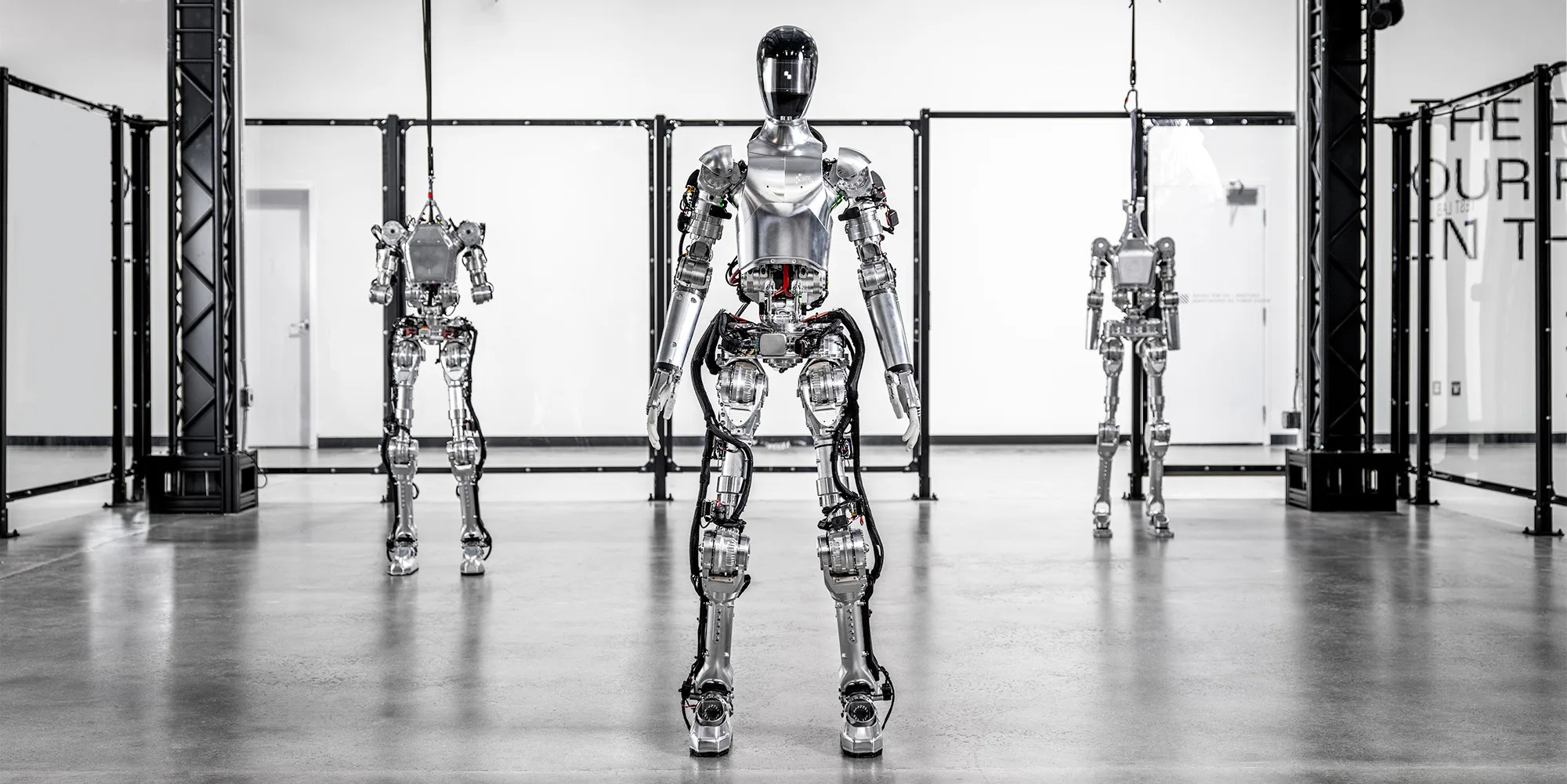

視覚・言語知能を獲得したAI搭載ヒト型ロボット

Figure 01

概要

「Figure 01」とは、Open AI社とFigure社のコラボレーションが生んだAI搭載のヒト型ロボット。Open AI社の大規模言語モデル「ChatGPT」の言語理解能力と、Figure社の視覚認識技術や運動制御技術により、エンドツーエンドの自然な会話や高度なタスクの実行が可能になった。従来、ヒト型ロボットは、ヒトによる遠隔操作やプログラミングが必要なものが一般的だった。一方、「Figure 01」は、テキスト、画像、音声といった異なる種類のデータを処理するマルチモーダルAIの実装により、正確な状況判断と推論が可能。複雑なタスクをヒトと変わらない速度で実行できる。自律的に考え、行動するロボットとして、サービス業や教育、介護など、多様なシーンでヒトとの協働が期待される。

なにがすごいのか?

「視覚言語モデル」で周囲の環境を把握し、迅速なタスク処理を実現

過去の経験情報を意思決定に反映

安全でバランスを保つ運動制御技術

なぜできるのか?

映像と言語の理解を可能にする「視覚言語モデル」

「Figure 01」では、カメラから入力された映像情報とマイクで収集した音声データを「視覚言語モデル(Vision Language Model)」で統合(音声は文字に変換してから入力)。これにより、実空間の座標など、周囲の環境をリアルタイムに把握できる。

迅速な反応を実現する「ニューラルネットワーク視覚運動変換ポリシー」

処理された周辺情報は、画素から行動を生成する「ニューラルネットワーク視覚運動変換ポリシー(Neural Network visuomotor Policies)」に入力される。「ニューラルネットワーク視覚運動変換ポリシー」は、画像特徴と動作特徴を融合し行動を生成する「Deep Visuomotor Policy」と、時系列に基づく複雑なタスクの習得を可能にする「Neural Network Visuomotor Tansformer Policies」から構成されており、遅延のない迅速な行動の実行を可能にする。

「記憶」が実現する高度な意思決定

「Figure 01」は、過去に遭遇した状況や、実行したタスクの結果をデータとして蓄積可能。過去の履歴と周囲の状況を組み合わせることで、常識的な推論に基づく意思決定が可能になる。

身体全体を安定させる運動制御技術

「Figure 01」では、Figure社独自の運動制御技術により、精密な動作が可能。「卓上のリンゴを選んで渡す」「カップや皿を水切りラックに入れる」といった複雑なタスクでも、バランスを保ちながら実行できる。

相性のいい産業分野

この知財の情報・出典

この記事のタグ